-

AI와 HPC를 위한 최적의 솔루션: PowerEdge XE9680와 InfiniBand 네트워크 구축 사례기술이야기/HPC 및 AI 2024. 12. 10. 14:51

저희 이스파이스는 최근 고객사에 Dell Technologies의 최상위급 8-GPU 서버인 PowerEdge XE9680를 총 40대 공급하였습니다.

각 서버에는 현재 최첨단 고속 네트워크 기술인 InfiniBand NDR(400Gbps) HCA(Host Channel Adapter)가 8개씩 장착되었으며, 고객의 요구에 따라 40개의 노드를 32개와 8개의 두 그룹으로 나누어 각각 non-blocking 모드로 구성하였습니다.

이러한 구성은 각각의 그룹이 요구하는 성능과 용도에 최적화된 네트워크 환경을 제공하며, 프로젝트의 유연성과 효율성을 극대화하였습니다.

이번 프로젝트는 대규모 고성능 컴퓨팅(HPC) 환경에서 최첨단 기술과 설계의 집약체로, 업계 내 모범적인 사례가 될 것이기에 이 프로젝트의 주요 구성 요소와 기술적 특징을 정리하여 공유하고자 합니다.

다룰 주요 내용은 다음과 같습니다:

- 시스템 사양 및 특징

- 네트워크 구성 설계

- GPU Direct 기술 소개

- 실제 구성

1. 시스템 사양 및 특징1.1 PowerEdge XE9680

Dell PowerEdge XE9680은 최대 8개의 NVIDIA H100 GPU와 4세대 Intel Xeon 스케일러블 프로세서를 지원하는 고성능 AI 및 HPC 서버로, 데이터 집약적 워크로드에 최적화된 탁월한 성능과 확장성을 제공합니다.

[그림1] PowerEdge XE9680

[표1] PowerEdge의 제품 사양

이번 프로젝트에 선정된 구체적인 사양은 다음과 같습니다.Dell PowerEdge XE9680 프로세서 (2) Intel Xeon Platinum 8480+ 2G, 56C/112T, 16GT/s, 105M Cache, Turbo, HT (350W) DDR5-4800 메모리 (32) 64GB RDIMM, 5600MT/s, Dual Rank, Total 2048GB (2TB) 저장장치 (OS) BOSS-N1 controller card + with 2 M.2 480GB (RAID 1) 저장장치 (데이터) 3.84TB Data Center NVMe Read Intensive AG Drive U2 Gen4 with Carrie 네트워크 어댑터 (이더넷) Mellanox ConnectX-6 DX Dual Port 100GbE QSFP56 Network Adapter, Full Height 네트워크 어댑터 (인피니밴드) Nvidia ConnectX-7 Single Port NDR OSFP PCIe, No Crypto, Full Height 전원 공급 장치 (6) Hot-Plug PSU, 2800W MM HLAC (200-240Vac) Titanium, C22 Connector

PowerEdge XE9680 서버는 NVLink를 통해 완벽하게 상호 연결된 8개의 NVIDIA H100 또는 H200 SXM5 700W GPU 모듈을 탑재한 최상위 GPU 서버입니다.

[그림2] PowerEdge XE960의 시스템 아키텍처

각 PCIe 스위치에는 2개의 GPU와 2개 또는 3개의 PCIe 확장 슬롯이 연결되어 있습니다. 이러한 설계를 통해 각 PCIe 스위치에 2개의 InfiniBand NDR HCA를 장착하여 모든 GPU가 가장 가까운 위치에 있는 InfiniBand HCA에 직접 접근할 수 있도록 최적화하였습니다. 이로 인해 GPU와 InfiniBand HCA 간의 데이터 전송 경로가 단축되어 지연 시간을 최소화하고 대역폭 효율을 극대화할 수 있습니다.

또한, 2개의 PCIe 슬롯에는 100Gbps 이더넷 어댑터를 장착하여 기본 통신 및 스토리지 네트워크로 활용하였습니다. 이를 통해 고속 연산 네트워크와 기본 네트워크를 분리하여 시스템 성능과 안정성을 더욱 강화하였습니다.

1.2 NVIDIA Quantum-2 InfiniBand 스위치 (QM97xx)

NVIDIA Quantum-2 InfiniBand 스위치는 400Gb/s의 처리량, 인-네트워크 컴퓨팅, 스마트 가속화 엔진, 유연성, 견고한 아키텍처를 제공하여 고성능 컴퓨팅(HPC), AI, 하이퍼스케일 클라우드 인프라에서 비용과 복잡성이 적으면서도 가장 뛰어난 성능을 달성합니다.항목 사양 포트 구성 64 x 400Gb/s NDR InfiniBand 포트 (32 OSFP 커넥터) 스위칭 용량 51.2Tb/s 양방향 처리량 패킷 처리 성능 665억 패킷/초 (BPPS) 이상 폼 팩터 1U 표준 섀시 디자인 전원 소비 - 패시브 케이블 사용 시: 747W (ATIS 기준) - 액티브 케이블 사용 시 최대: 1,720W 주요 구성 요소 - CPU: Intel® Core™ i3 Coffee Lake (QM9700에만 해당) - 스위치: NVIDIA Quantum™-2 IC 크기 및 무게 - 크기: 43.6mm (H) x 438mm (W) x 660mm (D) - 무게: 1 PSU: 13.6kg; 2 PSUs: 14.8kg 속도 지원 포트당 40, 56, 100, 200, 400 Gb/s 지원 환경 조건 - 작동 온도: 전면 공기 흐름: 0°~35°C; 후면 공기 흐름: 0°~40°C - 비작동 온도: -40°~70°C 인증 - 안전: CB, cTUVus, CE, CU, S-Mark - EMC: CE, FCC, VCCI, ICES, RCM - RoHS 준수

1.3 Dell S5232F-ON 100Gbps Ethernet 스위치

Dell PowerSwitch S5232F-ON은 32개의 100GbE 포트를 제공하는 고성능 1U 스위치로, 3.2Tbps의 스위칭 용량과 VXLAN, ONIE 지원을 통해 데이터 센터와 클라우드 환경에서 유연성과 효율성을 제공합니다.항목 사양 포트 구성 - 32 x 100GbE QSFP28 포트 - 2 x 10GbE SFP+ 포트 전송 용량 3.2Tbps (전이중 시 6.4Tbps) 전원 및 냉각 - 핫스왑 전원 공급 장치 (중복 가능) - 핫스왑 팬 (중복 가능) - 전면-후면 또는 후면-전면 공기 흐름 옵션 크기 및 무게 - 크기: 43.4cm(W) x 46.0cm(D) x 4.4cm(H) - 무게: 9.8kg 지원 포트 속도 10/25/40/50/100GbE 스위칭 기능 - L2 및 L3 이더넷 스위칭 - VXLAN 게이트웨이 기능 운영 체제 지원 - Dell SmartFabric OS10 - 오픈 네트워크 설치 환경(ONIE) - 타사 네트워크 운영 체제 지원 적용 환경 데이터 센터, 클라우드 서비스, 엔터프라이즈 환경 2. InfiniBand 네트워크 구성 설계

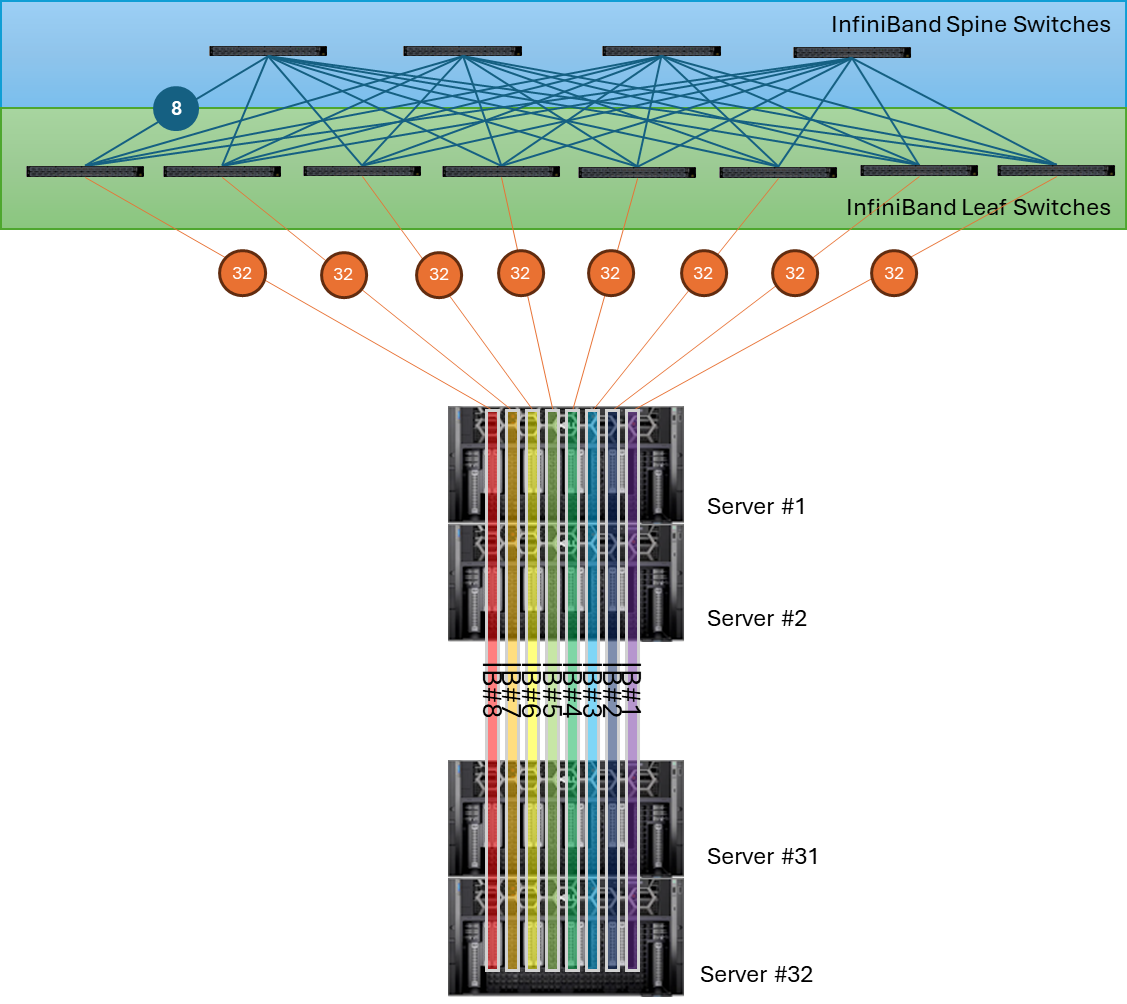

InfiniBand 네트워크에서 non-blocking 구성을 구현하려면 스위치의 업스트림 포트와 다운스트림 포트의 수가 동일해야 합니다. 즉, 스위치의 총 포트 수를 절반은 서버와 연결하는 다운스트림 포트로, 나머지 절반은 상위 스위치와 연결하는 업스트림 포트로 사용해야 합니다.

NVIDIA QM97xx 스위치는 64개의 400Gbps 포트를 제공합니다. 이를 기반으로, 각 스위치는:

- 32개의 포트를 서버 연결용(다운스트림)으로 사용

- 나머지 32개의 포트를 상위 스위치 연결용(업스트림)으로 사용해야 합니다.

즉, 현재 설치하고자 하는 32개의 8-GPU 서버를 연결하기 위한 InfiniBand 스위치의 수량은 다음과 같이 계산할 수 있습니다.

서버 연결 포트 계산: 각 서버에 8개의 InfiniBand NDR HCA가 장착되어 있으므로, 총 32대의 서버에서 필요한 포트는

- 32(서버) × 8(HCA) = 256포트

레벨-1 스위치 구성: 각 레벨-1 스위치는 32개의 포트를 서버와 연결하므로, 총 필요한 스위치 수는:

- (256 (필요 포트)) ÷ (32(서버 연결 포트⁄스위치)) = 8스위치

상위(레벨-2) 스위치 구성: 레벨-1 스위치 8개는 각각 32개의 업스트림 포트를 통해 레벨-2 스위치와 연결됩니다. 따라서 레벨-2 스위치에 필요한 포트 수는

- 8(레벨-1 스위치) × 32(업스트림 포트) = 256 포트

이를 수용하기 위해 각 레벨-2 스위치는 64포트를 가지므로, 필요한 레벨-2 스위치 수는:

- 256(필요포트) ÷ 64(포트⁄스위치) = 4스위치

이 전체 네트워크를 non-blocking 구성으로 설계하려면 다음과 같은 수의 스위치가 필요합니다.

- 레벨-1 스위치: 8개 (각 스위치가 32개의 IB HCA와 연결)

- 레벨-2 스위치: 4개 (레벨-1 스위치의 업스트림 포트를 처리)

서버와 스위치 간 연결 설계

각 서버의 8개 HCA는 각각 레벨-1 스위치 8개에 균등하게 연결되며, 데이터 트래픽이 고르게 분산되도록 설계되었습니다. 이를 통해 HCA 간 균등한 트래픽 분배가 가능하며, 서버에서 발생하는 모든 데이터가 레벨-1 스위치로 고르게 분산됩니다.

레벨-1과 레벨-2 스위치 간 연결 설계

각 레벨-1 스위치는 8개의 포트를 사용하여 각각의 레벨-2 스위치와 연결해야 합니다. 즉, 레벨-1 스위치 8개와 레벨-2 스위치 4개가 상호 연결되어, 총 8 × 8 = 64개의 연결이 레벨-2 스위치에 형성됩니다. 이 설계를 통해 레벨-1과 레벨-2 스위치 간의 트래픽이 non-blocking으로 유지되고, 각 HCA에서 레벨-1 스위치를 거쳐 레벨-2 스위치로 이동하는 데이터 경로가 균등하게 분배됩니다.

[그림3] 256 노드에 대한 InfiniBand NDR non-blocking 연결 이런 설계를 통해 균형 잡힌 네트워크 트래픽 분배가 가능하고, 최소한의 지연시간을 확보할 수 있습니다. 또한, 연결에 장애가 생기더라도 전체 통신에 큰 지장을 피할 수 있습니다.

3. GPU Direct RDMA 기술 소개

[그림 4] NVIDIA의 GPU Direct RDMA 개

GPU Direct RDMA는 PCIe 장치가 GPU 메모리에 직접 접근할 수 있도록 설계된 기술로, CPU와 메모리를 경유하지 않아 데이터 전송 지연을 제거하고 최대 10배의 성능 향상을 제공합니다. 앞서 언급한 InfiniBand 네트워크 구성은 이 GPU Direct RDMA 기술에 최적화된 설계로, 고속 네트워크와 non-blocking 구조를 통해 GPU 간의 직접 통신을 지원합니다.이를 통해:

- 시스템 CPU와 메모리를 경유하지 않는 효율적인 데이터 전송 경로를 제공

- 데이터 복사로 인한 지연 시간을 제거

- GPUDirect RDMA의 성능을 최대화

특히, 각 서버에 장착된 8개의 InfiniBand HCA는 GPU 간 병렬 처리를 완벽히 지원하며, 레벨-1 및 레벨-2 스위치로 구성된 네트워크는 트래픽 병목현상을 방지하여 대규모 고성능 컴퓨팅 환경에서 최적의 성능을 보장합니다.

다음은 실제로 시스템에서 GPU와 InfiniBand간의 연결 토폴로지를 확인한 결과입니다.

[그림 6] NVIDIA GPU와 네트워크 어댑터 간의 토폴로지

GPU 간 연결:- NVIDIA NVLink를 통해 연결되어 있으며, 높은 대역폭과 낮은 지연 시간을 제공합니다.

GPU와 NIC 간 연결:- PIX로 표시된 조합은 동일한 PCIe 스위치에 연결된 상태를 나타내며, 이를 통해 GPU Direct RDMA를 지원하는 최적의 데이터 전송 경로를 형성합니다.

이와 같이, InfiniBand와 GPU Direct RDMA 기술이 결합된 구성은 고성능 컴퓨팅 환경에서 효율적이고 안정적인 데이터 전송을 구현합니다.4. 실제 구성

잘 설계된 인피니밴드 네트워크를 구현하려면 적절한 케이블 선정과 효율적인 포트 배치가 필수적입니다. 복잡한 구성이지만, 깔끔한 연결과 최적의 비용 절감은 구축 업체의 경험과 노하우에 크게 좌우됩니다.

4.1 포트 배치

수백 개의 케이블을 체계적으로 라우팅하여 최적의 연결 경로를 선정하고, 필요한 케이블 길이를 정확히 계산해야 합니다.

명확한 레이블링과 체계적인 배치는 유지 관리와 장애 대응을 크게 단순화합니다.4.2 케이블 선정

네트워크 요구 사항에 따라 패시브 동선, 액티브 동선, 또는 광섬유 케이블을 신중히 선택해야 합니다.

NVIDIA의 공식 자료를 기반으로, 이번 프로젝트에서는 멀티모드 트랜시버와 케이블을 사용해 구성했습니다.

[그림 7] InfiniBand NDR 인터커넥트 종류 트랜시버-케이블 일체형 구성이 더 저렴할 수 있었으나, 고객의 요청에 따라 트랜시버와 케이블을 개별적으로 구성했습니다. 잘못된 케이블 선택은 성능 저하와 추가 비용을 초래할 수 있습니다.

InfiniBand 케이블만 총 512개가 연결된 이번 프로젝트는, 사전에 철저한 설계와 계획 덕분에 스위치 간 연결과 스위치-노드 간 연결이 깔끔하게 정리되었습니다. 아래는 완성된 네트워크의 체계적이고 정돈된 모습입니다:

[그림 8] 최종적으로 구현된 256 GPU의 InfiniBand 연결 InfiniBand 네트워크의 효율적인 관리와 안정성을 위해, Spine 스위치 중 2대를 관리형 스위치(Managed Switch)로 구성하여 Subnet Manager를 해당 스위치에서 실행하도록 설정했습니다. 이를 통해 경로 설정 및 관리 작업이 최적화되었으며, 대규모 네트워크 환경에서도 안정적인 운영이 가능하도록 설계하었습니다.

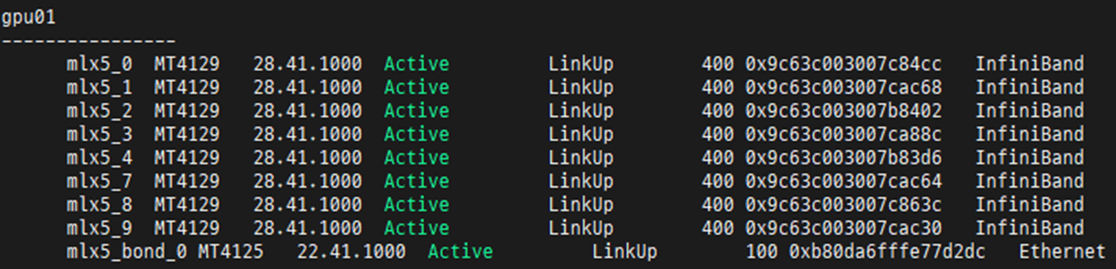

케이블 포설까지 마친 후에 전체 노드에 대해 모든 네트워크가 400Gbps로 제대로 연결되었는지 확인하였습니다.

[그림 9] 각 노드의 InfiniBand 네트워크 상태 확인 이처럼 최적의 네트워크 구현은 구축 업체의 전문성과 세심한 설계가 필수적입니다. 복잡한 구성이라도 정확한 설계와 노하우가 적용되면, 안정성과 성능을 극대화할 수 있습니다. 이는 프로젝트 성공의 핵심 요소라고 할 수 있습니다.

저희 이스파이스는 20년 가까이 축적된 InfiniBand 구축 경험과 전문성을 바탕으로, 고객의 요구를 충족하는 최적의 네트워크 환경을 구현했습니다. 이번 프로젝트는 최신 기술과 설계 노하우를 결합한 성공적인 사례로, 고객의 비즈니스 가치를 한 단계 높였습니다.

(주)이스파이스는 Dell Technologies의 Titanium 파트너로, HPC/AI에 특화된 제품군과 서비스를 제공합니다. 또한, HPC/AI 연산에 최적화된 병렬 파일 시스템인 BeeGFS의 국내 유일 파트너로서 구축 및 서비스를 지원하고 있습니다.

제품 및 서비스에 대한 문의는 전화 02-573-1484~5 또는 이메일 espice@espice.co.kr로 연락 주시기 바랍니다.'기술이야기 > HPC 및 AI' 카테고리의 다른 글

제 64회 TOP500 슈퍼컴퓨터 랭킹 이야기 (0) 2024.12.04 제 63회 TOP500 수퍼컴퓨터 랭킹 분석 (2024.06) (0) 2024.05.21 제 62회 TOP500 수퍼컴퓨터 랭킹 분석 (2023.11) (0) 2023.12.05 제 60회 TOP500 슈퍼컴퓨터 랭킹 분석 (2022.11) (0) 2022.11.22 제59회 TOP500 슈퍼컴퓨터 랭킹 이야기 (2022.06) (0) 2022.06.10