-

고성능 인프라를 위한 필수 선택: NFS over RDMA 성능 검증 결과시스템 설정 가이드/서버 2026. 2. 6. 14:41

최근 HPC(고성능 컴퓨팅)와 AI 인프라가 급격히 확산되면서 100GbE 이상의 초고속 네트워크 도입이 일반화되고 있습니다. 하지만 아무리 빠른 네트워크를 갖추더라도 기존의 TCP/IP 기반 NFS 환경에서는 커널 스택의 오버헤드로 인한 지연 시간(Latency) 이슈가 스토리지 성능의 발목을 잡곤 합니다.

최근의 서버 OS에서는 NFS over RDMA 기능을 지원하여, 초고속 저지연 네트워크에 대응하는 NFS 설정이 가능하게 되었습니다. 이에 저희 이스파이스 내부적으로 실제 성능(대역폭, IOPS, 지연 시간)이 얼마나 개선되는지 직접 테스트를 통해 확인해 보았습니다.

1. 테스트 환경

이번 NFS 테스트에는 다음과 같은 환경에서 수행되었습니다.

NFS 서버 NFS 클라이언트 네트워크 어댑터 ConnectX-5 ConnectX-7 OS Rocky Linux 9.7 Ubuntu 24.04.3 두 시스템은 100GbE 케이블로 직접 연결되었으며, 효율적인 전송을 위해 MTU는 9000으로 설정하였습니다.

2. NFS over RDMA 설정

NFS over RDMA는 RHEL 9 계열 이상에서 안정적인 지원을 제공합니다.

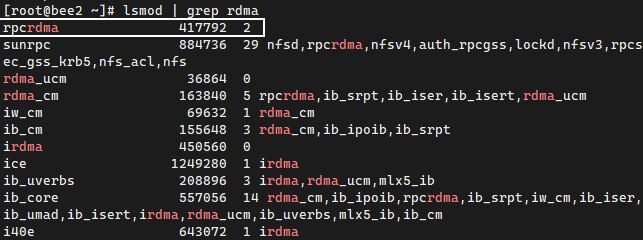

서버 설정: /etc/exports 설정 후 RDMA 활성화 시, lsmod 명령어를 통해 rpcrdma 관련 모듈이 로드된 것을 확인할 수 있습니다.

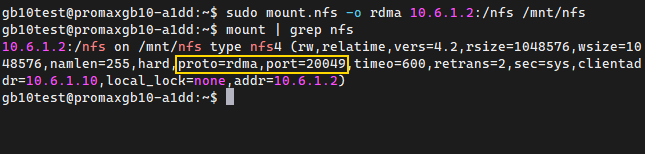

클라이언트 설정: 마운트 시 proto=rdma 옵션을 추가합니다. 마운트 완료 후 mount | grep nfs를 통해 port=20049와 proto=rdma가 정상 적용된 것을 확인했습니다.

3. 성능 비교 테스트 결과 (fio benchmark)

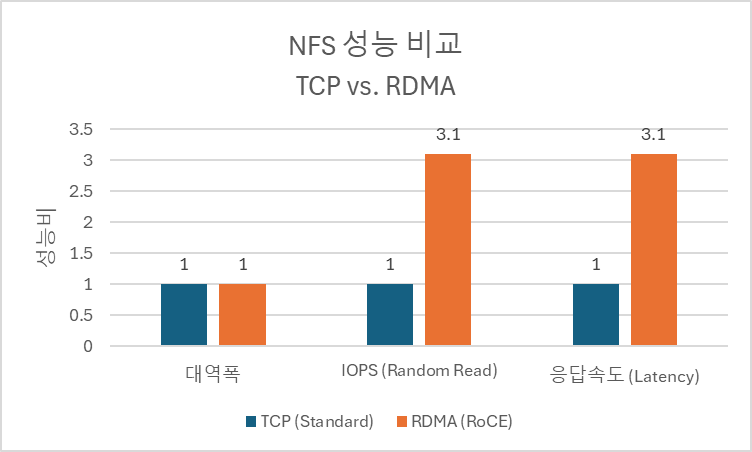

TCP 마운트와 RDMA 마운트의 성능 차이를 확인하기 위해 fio 툴을 이용해 대역폭과 IOPS를 측정했습니다.

분석

- 대역폭: 테스트 노드에 탑재된 NVMe 스토리지의 물리적 한계치에 도달하여 두 방식 모두 비슷한 결과를 보였습니다.

- IOPS 및 Latency: RDMA 적용 시 응답 속도가 3.1배 빨라졌으며, 이는 곧바로 초당 입출력 횟수(IOPS)의 3.1배 증가로 이어졌습니다.

- 시스템 효율성: RDMA의 Zero-Copy 기술 덕분에 CPU는 불필요한 메모리 복사 작업에서 벗어나, 더 적은 리소스로 더 많은 I/O를 처리할 수 있었습니다.

4. 마무리

테스트 결과, RDMA는 NVMe SSD 스토리지와 고속 네트워크 환경에서 NFS의 성능 잠재력을 극대화하는 핵심 기술임을 확인할 수 있었습니다. 특히 데이터 읽기/쓰기가 빈번한 AI 및 HPC 환경에서는 전통적인 서버 기반의 NFS 서비스에 RDMA 도입만으로도 드라마틱한 성능 향상을 기대할 수 있습니다.

고속 네트워크 환경에서 전통적인 NFS를 사용하고 계신다면, (주)이스파이스가 최적의 구성을 제공해 드릴 수 있으니 언제든 상담 및 문의 주시기 바랍니다.

(주)이스파이스는 Dell Technologies의 Titanium 파트너로서, 최신 x86 서버와 다양한 스토리지 제품군 및 서비스를

제공하고 있습니다. 또한, HPC/AI 연산에 최적화된 스토리지 솔루션을 보유하여 전문적인 구축 및 서비스를 지원합니다.

전화: 02-573-1484~5

이메일: espice@espice.co.kr